À quel point êtes-vous sûr que la personne avec qui vous « débattez » passionnément en ligne est une vraie personne qui respire ? Comment savez-vous s'il s'agit simplement d'un autre partisan passionné d'un sujet quelconque et non d'une personne soutenue par le gouvernement (ou autre) ?

Repérer les robots russes ou les complices payants n'est pas une tâche facile. Cependant, cela devient de plus en plus important à mesure que les accusations d'États-nations s'ingérant dans les affaires des autres continuent de tourbillonner. Pouvez-vous les repérer? Voici ce que vous devez savoir.

Commençons par différencier les bots et les shills.

Bot : Un bot est un faux compte de réseau social sous le contrôle d'une organisation ou d'un gouvernement cherchant à influencer la communauté en ligne. Par exemple, un bot Twitter configuré pour retweeter certains hashtags et phrases dans des volumes tels qu'il amplifie le sujet spécifique. Un autre exemple est celui des bots Reddit qui votent contre les vues en désaccord avec l'opinion du contrôleur de bot (tout en votant pour celles qui sont d'accord). Les robots ont besoin de volume pour réussir sur certaines plates-formes, tandis qu'à d'autres moments, seuls quelques-uns peuvent commencer à façonner la direction d'une conversation. Et n'importe qui peut créer un bot de médias sociaux en utilisant Python.

Shill : Un complice est différent. Les shills sont de vraies personnes qui s'engagent activement dans la formation de discussions et d'opinions en ligne (dans ce cas) --- tout en recevant un paiement en échange de leur présence. Les shills font la promotion d'entreprises, de gouvernements, de personnalités publiques et bien plus encore, à des fins personnelles, en se livrant essentiellement à la propagande.

Selon l'organisation ou le gouvernement, les shills peuvent travailler en conjonction avec de grands réseaux de robots pour créer des mouvements vocaux en ligne intenses. Et bien que les efforts combinés des complices et des bots façonnent l'opinion en ligne, ces efforts touchent de plus en plus bien plus que les utilisateurs des réseaux sociaux.

La pratique est également connue sous le nom d'astroturfing , où les organisations et les gouvernements organisent la conversation par l'intermédiaire de membres "réguliers" du public.

Les robots et complices russes ont dominé les discussions à l'approche de l'élection présidentielle américaine de 2016. Les commentateurs et les critiques ont consacré une énorme quantité de temps d'antenne et de colonnes à discuter du rôle des robots et complices soutenus par la Russie pour influencer la discussion autour de certains sujets.

En fait, Robert Mueller, l'avocat spécial qui enquête sur l'ingérence dans l'élection présidentielle, a récemment inculpé 13 Russes basés aux États-Unis dans le cadre de la machine de propagande présumée soutenue par la Russie, Internet Research Agency (IRA).

Les allégations d'influence vont loin. Ils vont de la simple création d'identités à consonance américaine en ligne, au vol de l'identité de citoyens américains, en passant par l'appâtage des militants des minorités et des soi-disant "guerriers de la justice sociale", jusqu'à la création de groupes Instagram tels que "Woke Blacks" pour influencer les efforts de vote des minorités. Et il y a aussi de nombreux autres exemples.

Les réseaux sociaux sont l'un des principaux outils d'influence. Les plateformes savent aussi qu'il y a un problème. En janvier 2018, Twitter a déclaré qu'il envoyait un e-mail à 677 775 personnes aux États-Unis qui avaient tweeté du contenu de l'IRA. En même temps que les excuses, Twitter purge les comptes de robots, incitant le hashtag #twitterlockout à se développer parmi les utilisateurs de Twitter à prédominance conservatrice.

Et pour tous les cris de jeu déloyal et de ciblage injuste, il est prouvé que "les conservateurs ont retweeté les trolls russes environ 31 fois plus souvent que les libéraux et ont produit 36 fois plus de Tweets".

De plus, Twitter maintient que leur purge de bots est "apolitique" et qu'ils appliquent des règles à l'échelle du site "sans parti pris politique".

Cela ne veut pas dire que les robots, les complices et l'astroturfing sont la seule compétence des personnalités conservatrices.

Dès 2007, les membres du personnel de campagne de Clinton stimulaient anonymement les sites pro-Hilary, tandis que lors des débats présidentiels de 2016, la campagne de Clinton a fait l'objet de centaines de milliers de tweets de robots automatisés (bien que nettement moins que Donald Trump).

Twitter et d'autres plateformes de médias sociaux ne sont pas infestés de bots, comme certaines publications voudraient vous le faire croire. Nous pouvons décomposer l'interaction des hashtags des bots Twitter pour comprendre comment leurs contributeurs cherchent à influencer la conversation.

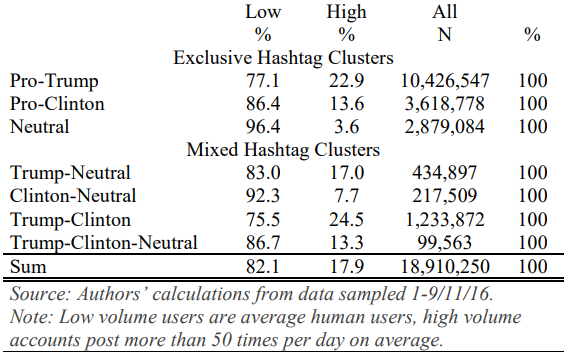

Le Computational Propaganda Project (CCP), parrainé par l'Université d'Oxford, examine de près ces interactions. Le tableau ci-dessous illustre [PDF] la différence d'automatisation entre les interactions avec les hashtags pro-Trump ou pro-Hilary, ainsi que le pourcentage global de tweets non automatisés, entre le 1er novembre et le 9 novembre 2016 :

Le PCC définit une automatisation élevée comme "des comptes qui publient au moins 50 fois par jour" en utilisant au moins l'un des hashtags spécifiques aux élections. L'étude considère tout ce qui est en dessous de ce seuil d'automatisation faible --- en d'autres termes, une personne réelle. Le tableau montre un pourcentage beaucoup plus élevé d'automatisation de bas niveau, ce qui indique qu'un nombre beaucoup plus élevé d'utilisateurs réguliers interagissent.

L'étude note que certains utilisateurs humains sont inévitablement entraînés dans la tranche d'automatisation élevée. Il note également que les comptes démontrant une automatisation élevée utilisent également très rarement des termes du support Mixed Hashtag Cluster (à l'exception des combinaisons Trump-Clinton en raison du volume de retweet).

Nous ne connaîtrons jamais vraiment l'image complète du nombre de bots travaillant sur une plate-forme de médias sociaux donnée. Des recherches récentes estiment [PDF] que les robots automatisés représentent près de 15 % de tous les utilisateurs de Twitter, ce qui porte le total à plus de 40 millions de comptes de robots individuels .

Un excellent exemple de l'influence russe directe est la manifestation de 2016 au Houston Da'wah Center.

Le groupe Facebook "Heart of Texas" a publié une annonce à la recherche de sympathisants pour assister à une manifestation "pour arrêter l'islamisation du Texas". La manifestation a été fixée à midi le 21 mai, réunion au centre Da'wah. Au même moment, un autre groupe --- les soi-disant "Musulmans unis d'Amérique" --- organisait une contre-manifestation au même moment et au même endroit.

Les deux groupes se sont rencontrés au centre et, comme on pouvait s'y attendre, "les interactions entre les deux groupes ont finalement dégénéré en confrontation et en attaques verbales".

À l'époque, aucun groupe de manifestants n'a réalisé que leur groupe respectif n'était pas réel. C'est-à-dire; les groupes étaient la construction d'une "ferme de trolls" soutenue par la Russie qui n'existe que pour manipuler les tensions politiques, raciales et religieuses aux États-Unis.

Reconnaître les bots et complices sur les réseaux sociaux n'est pas toujours facile. Pourquoi? Parce que sinon plus les gens se rendraient compte de ce qui se passait.

Ne vous méprenez pas; nous interagissons tous avec des robots et des complices, c'est la nature même des médias sociaux en 2018. Les agents reçoivent des milliers de dollars par mois pour influencer subtilement (et parfois plus effrontément) la conversation.

Il y a cependant quelques conseils de détection de robots à garder à l'esprit :

Les autres éléments à surveiller sont les votes négatifs systémiques automatiques sur des sites comme Reddit. Les robots reprennent le titre d'une soumission et commencent immédiatement à rejeter les commentaires qui ne sont pas d'accord avec leur programmation. (Le vote négatif masque les commentaires ainsi que leurs réponses des autres utilisateurs, et constitue un moyen facile d'obstruer les opinions dissidentes.)

Repérer les complices payants est plus difficile car il incombe au compte de maintenir l'apparence d'un utilisateur régulier des médias sociaux. Les messages faisant la promotion d'un certain sujet ou façonnant la conversation en ligne peuvent figurer parmi les points de discussion banals réguliers pour ne pas créer de suspicion.

Certaines tactiques courantes incluent :

Une autre tactique de repérage est le cycle humain. Les gens ordinaires doivent dormir, manger, boire, etc. Si un seul compte parvient à publier sur un seul agenda en continu pendant des périodes de 24 heures, il se passe probablement quelque chose.

Mais les "vraiment bons" complices travaillent dur. Au lieu de simplement attaquer et contredire l'opinion et tenter de façonner la discussion, ils se lieront lentement d'amitié et s'infiltreront dans un groupe avant de se mettre au travail.

Malheureusement, à part signaler les comptes suspects, il y a peu de mesures directes à prendre contre les comptes shill ou bot. Comme on dit, ne nourrissez pas les trolls.

Les élections de mi-mandat de 2018 sont maintenant fermement à l'horizon (vérifiez le parti pris politique de tout site à l'approche). Alors que l'impact des comptes shill et bot est peut-être plus important que jamais, vous en savez maintenant plus sur la façon de repérer certains types de comportement.

Cependant, Twitter n'est pas que des bots et des trolls. Les médias sociaux peuvent avoir un impact positif sur le monde.

Crédit image :raptorcaptor/Depositphotos